Startseite » Wissen » SEO » Crawling-Budget

Crawling Budget – Definition, Einflussfaktoren & Bedeutung

Der Googlebot – ein Mysterium. Wie oft und warum kommt er auf die eigene Seite? Oft wird fälschlicherweise angenommen, dass man hier selbst keine Kontrolle hat. Allerdings lässt sich mit Hilfe von gezielten Optimierungen das Crawling-Budget durchaus beeinflussen.

Was ist das Crawling-Budget?

Grob gesagt gibt das Crawling-Budget die Anzahl an URLs an, welche der Googlebot crawlen kann und will. Es setzt sich dabei aus zwei Komponenten zusammen:

Dem crawl demand (Crawling Bedarf) und dem crawl rate limit (Crawling-Kapazitätslimit). Beide sind dementsprechend wichtig und sollten getrennt voneinander betrachtet werden.

Crawling-Kapazitätslimit

Das Crawling-Kapazitätslimit wird anhand von drei von Google selbst genannten Faktoren festgelegt. Diese sind:

- Der Crawling Status

Wird eine Website vom Googlebot gecrawlt, kann diese entweder schnell reagieren oder langsamer werden und im schlimmsten Fall sogar mit Serverfehlern (5xx-Fehler) antworten.

Je nachdem, welcher der beiden Fälle eintritt, wird das Limit der verwendeten Verbindungen erhöht oder verringert.

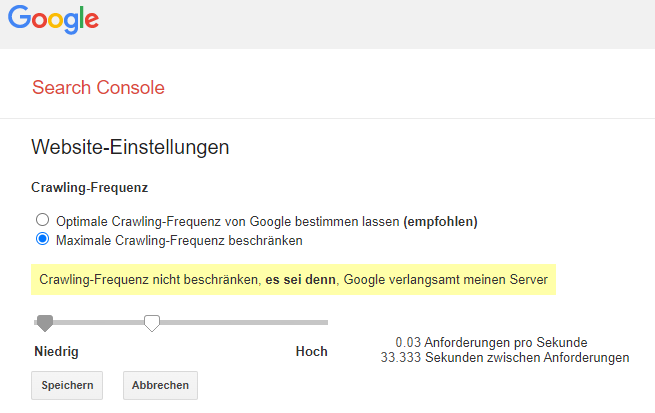

- Ein durch den Websiteinhaber in der Search Console festgelegtes Limit

Die Crawling-Frequenz kann auch von Websiteinhabern selbst manuell beschränkt oder erhöht werden. Das Begrenzen ist vor allem dann sinnvoll, wenn die Serverleistung der eigenen Website sehr gering ist und damit gerechnet werden muss, dass die Nutzerfreundlichkeit unter einer zu hohen Crawling-Frequenz des Googlebots leiden würde.

Allerdings muss hier auch berücksichtigt werden, dass das Crawling nicht automatisch erhöht wird, nur weil höhere Limits festgelegt werden.

- Googles Crawling-Limits

Selbst Google hat keine unbegrenzten Ressourcen. Deshalb muss auch hier mit der vorhandenen Rechnerkapazität gehaushaltet werden.

Crawling Bedarf

Der Crawling Bedarf wird hingegen vorwiegend von Komponenten bestimmt, die den Inhalt/Content einer Seite betreffen. Hier spielen zum Beispiel die Relevanz, die Aktualisierungshäufigkeit und die Seitenqualität eine Rolle. Zusätzlich kommt es auch auf die Größe der Website an.

Google selbst nennt drei Faktoren, die für die Bestimmung des Crawling-Bedarfs verwendet werden:

- Wahrgenommenes Inventar

Darunter fallen Duplikate, entfernte Seiten oder unwichtige Seiten, welche viel Zeit beim Crawling verbrauchen und damit Crawling-Budget verschwenden. Google sieht das nicht gern, weshalb sich obsolete Inhalte negativ auswirken. Hier können Websiteinhaber aber selbst einige wichtige Einstellungen treffen, welche weiter unten erklärt werden. - Beliebtheit

URLs die sehr beliebt sind, möchte Google aufgrund ihrer Popularität auch im Index aktuell halten und crawlt diese deshalb häufiger. - Aktualität

Google will seinen Nutzern wichtige Änderungen natürlich nicht vorenthalten und versucht deshalb zu verhindern, dass sich veraltete URLs im Index befinden.

Hierzu gibt es auch von John Müller zwei aktuelle Aussagen:

Zum einen erklärte er in den Google Search Central SEO Office Hours vom 18. Februar, dass der größte Anteil des Crawlens für die Aktualisierung bestehender Inhalte verwendet wird.

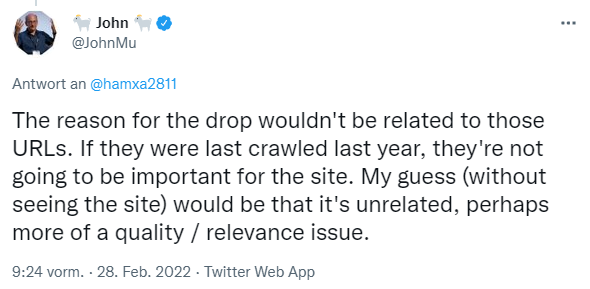

Zum anderen antwortete er auf die Frage, warum die Seite eines Websiteinhabers auf einmal weniger Klicks aus der Suche erhalte mit folgendem Tweet:

Das Datum des letzten Crawlens kann also einen Hinweis darauf geben, für wie wichtig Google eine Seite hält.

Zusammengefasst wird das Crawl-Budget also von der Kapazität, die ein Crawler auf einer Website aufwenden möchte und der Menge an Crawling-Anfragen die der Server der Website unterstützen kann, beeinflusst.

Welche Rolle spielt das Crawling-Budget in der Suchmaschinenoptimierung?

Nur wenn eine Seite gecrawlt wird, kann sie anschließend indexiert werden, um dann letztendlich in den Suchergebnisseiten zu ranken. Mehr Crawling-Budget bedeutet allerdings nicht automatisch bessere Rankings. Wichtig ist für die Suchmaschinenoptimierung vor allem, dass das vorhandene Crawl Budget bestmöglich ausgenutzt wird.

Für kleinere Websites mit wenigen URLs ist das Crawling-Budget meist ausreichend und bedarf keiner Optimierungsmaßnahmen. Allerdings sieht das für große Websites mit mehreren 10.000 bis Millionen URLs, deren Inhalt sich häufig oder sogar täglich ändert, etwas anders aus. Auch neuere Websites, deren Inhalt für Google noch unbekannt ist, haben anfangs oft ein eher geringeres Crawling-Budget. Das liegt vor allem daran, dass die Suchmaschine noch nicht weiß, ob es sich lohnt die Inhalte zu crawlen und zu indexieren.

Generell gilt: Wenn man wichtige Seiten hat, die nicht oft genug gecrawlt werden, sollte man sich das genauer anschauen. Denn das kann sich negativ auf das Ranking in den Suchmaschinen auswirken. Welche Möglichkeiten zur Überprüfung es gibt, klären wir gleich.

Die Crawl Aktivität überprüfen:

Am besten eignet sich dafür der Crawl-Statistikbericht in der Google Search Console. Diesen findet man in der Search Console unter “Einstellungen” im Reiter “Crawling”.

Hier empfiehlt es sich, nach großen Ausschlägen, Rückgängen und Tendenzen Ausschau zu halten. Wenn man zum Beispiel einen erheblichen Rückgang der gesamten Crawl-Anfragen feststellt, sollte man sich dies genauer anschauen.

Der markierte Crawl-Status gibt zusätzlich Aufschluss über Probleme, die Google beim Crawlen der Seite hatte. Idealerweise sollte der Host Status Grün sein. Ist er es nicht, kann man tiefer graben und den Grund für die Probleme einsehen, um ihn anschließend zu beheben.

Eine weitere Möglichkeit, Veränderungen im Crawling-Verhalten festzustellen, wäre sich die Logdateien des Servers anzusehen. Oft werden dafür aber spezielle Tools benötigt, weshalb viele den Bericht der Search Console bevorzugen.

Was wirkt sich negativ auf das Crawling-Budget aus?

Einen negativen Einfluss auf das Crawlen haben vor allem URLs mit wenig Mehrwert oder minderwertiger Qualität. Darunter fallen zum Beispiel:

- Duplicate Content

- Session-IDs

- Infinite Spaces

- Facettierte Navigation

- Spam

Aber auch technische Probleme wie Soft Errors oder lange Weiterleitungsketten können das Crawl-Budget negativ beeinflussen.

Wie kann ich das Crawling-Budget positiv beeinflussen?

Zum einen kann die technische Performance der Seite optimiert werden. Das heißt, dass auf eine schnelle Ladezeit der Website geachtet wird. Eine hohe Geschwindigkeit ist ein Zeichen für einen intakten Server und wirkt sich damit sowohl auf das Crawling-Kapazitätslimit, als auch auf die Nutzerfreundlichkeit positiv aus.

Weitere wichtige Tipps sind:

- Die robots.txt richtig nutzen

Unwichtige Seiten wie zum Beispiel Logins, Warenkorb, Danke-Seiten usw. können damit vom Crawling ausgeschlossen werden.

- Die Sitemap aktuell halten

In der Sitemap sollten nur kanonische, indexierbare URLs aufgeführt werden, welche für die Suchmaschine und den Websiteninhaber wichtig sind.

- Die Website Struktur einfach halten

Alle Seiten sollten einfach zu erreichen sein und nicht in “Sackgassen” enden. Der Crawler sollte also alle Unterseiten einfach erreichen oder finden können.

- Den Content aktuell halten und pflegen

Das Aktualisieren des Contents führt dazu, dass Google diesen aktuell halten will und häufiger crawlt. Gleichzeitig spart das entfernen von nicht mehr relevantem Content oder Duplicate Content Crawling-Budget ein. - Interne Links verwenden und pflegen

Google bewertet Seiten, die häufig verlinkt werden, positiv. Zusätzlich ist es wichtig, defekte Links zu reparieren, da diese sonst Crawling-Budget verschwenden.

- Lernen Sie uns unverbindlich kennen: